From Text-RAG to Vision-RAG with Cohere

From Text-RAG to Vision-RAG with Cohere: Why Visual Data Finally Gets Its Turn

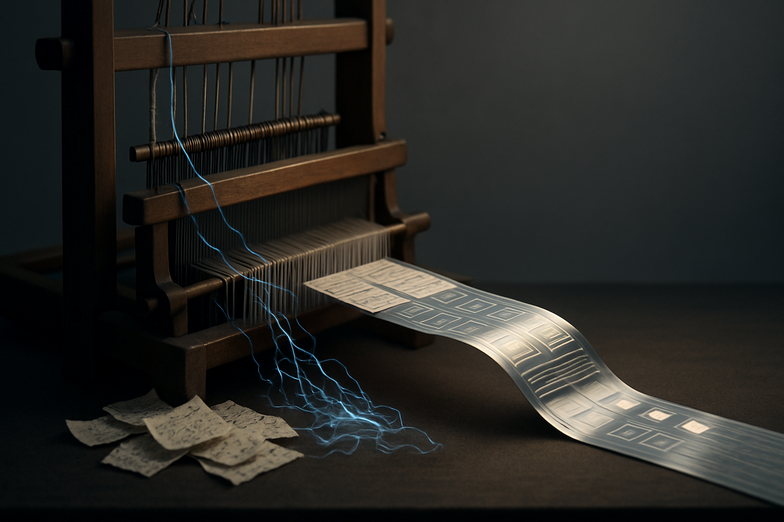

If you’ve ever fed a pile of PDFs or slides into a RAG system and felt frustrated that the charts and diagrams were ignored, you’re not alone. Most enterprise knowledge lives in images, not just plain text. That’s where Vision-RAG comes in, and yes, it’s a game changer.

I remember onboarding a client who had the best dashboards, but our search answers only used the captions, not the charts themselves. It felt wrong. Vision-RAG lets us extract meaning from visuals, using things like vision embeddings and multimodal LLMs to connect text and images, so the system actually understands what a chart is saying.

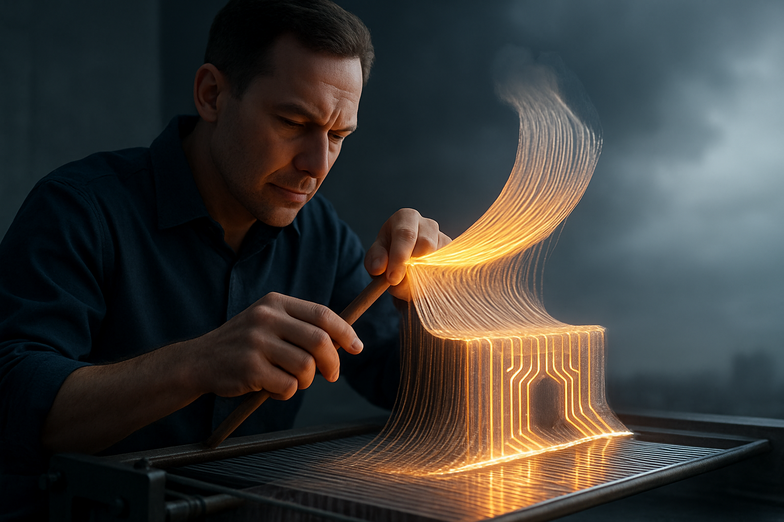

The course hosted by Jason Liu and Nils Reimers (607 students already curious) breaks this down into practical skills: build end-to-end Vision-RAG systems, implement vision embeddings and LLMs, and bridge text-visual modality gaps. Jason brings hands-on IR and RAG experience, and Nils brings deep model training expertise from Cohere, so you get both the why and the how.

Practical examples? Imagine a legal team who can query diagrams in contracts, or a product team that asks for trends from embedded charts across quarterly reports, and actually gets useful answers. That’s high-value stuff for enterprises, and it’s a skill set that’s in demand right now.

I don’t want to oversell it, but learning Vision-RAG positions you for meaningful projects, and it’s fun to build. Want to explore the lesson? Check it out here: From Text-RAG to Vision-RAG with Cohere.

Looking ahead, multimodal systems will keep closing the gap between how information is created and how we retrieve it, and you’ll be well placed if you jump in now.

Von Text-RAG zu Vision-RAG mit Cohere: Warum visuelle Daten endlich zählen

Viele Unternehmen speichern Wissen in Diagrammen, Infografiken und Dashboards, aber klassische RAG-Systeme lesen meist nur Text. Das fühlt sich oft unvollständig an. Vision-RAG ändert das, weil es Bilder, Charts und Text zusammenbringt.

Aus eigener Erfahrung: Ich habe Projekte gesehen, in denen wichtige Trends nur in Bildern standen, und unsere Modelle sie einfach übersahen. Mit Vision-RAG lässt sich das ändern, durch Vision-Embeddings und multimodale LLMs, die die Lücke zwischen Bild- und Textinformationen schließen.

Der Kurs von Jason Liu und Nils Reimers erklärt genau das: End-to-End-Systeme bauen, Vision-Embeddings implementieren, und Modalitäten verbinden. Jason kennt Retrieval und RAG aus der Praxis, Nils trainiert Modelle bei Cohere, also bekommst du sowohl praktische Tipps als auch fundiertes Modellwissen.

Das ist kein reines Forschungs-Thema. Stell dir vor, Rechtsabteilungen können Diagramme in Verträgen abfragen, oder Produktteams extrahieren Trends aus Quartalscharts. Solche Fähigkeiten sind in Unternehmen gefragt, das heißt, du bekommst konkrete, gut bezahlte Chancen.

Wenn du dich weiterbilden willst, hier ist der Kurslink: From Text-RAG to Vision-RAG with Cohere. Kurz gesagt, Vision-RAG macht Daten kompletter, und wer das früh lernt, steht gut da.

Kommentar abschicken