MotionStream: Real-Time Video Generation with Interactive Motion Controls

MotionStream: Real-Time Video Generation with Interactive Motion Controls

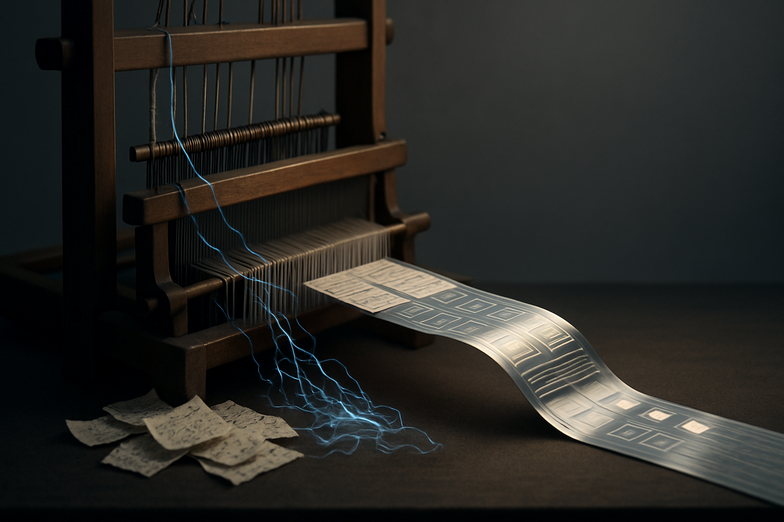

Have you ever wanted to steer a video like you’re driving a car, nudging the scene this way or that in real time? That’s exactly what MotionStream aims to do. It’s a system for **real-time, motion-controlled video generation**, letting creators stream arbitrarily long videos while directly controlling motion, frame by frame, or with broad gestures. I dug into the demo, and yeah, it feels a little like painting with movement, messy in a lovely way.

Quick context, then the good stuff. Video generation has traditionally been offline, slow, and brittle. You’d render a chunk, hope it lines up, then tweak and render again. MotionStream flips that, enabling continuous generation for interactive applications like live performance visuals, game scenes, or immersive installations. It keeps temporal coherence so the video doesn’t jitter when you guide it, which is huge.

So how it matters to you: imagine a musician controlling visuals with hand motions on stage, a game designer tweaking camera trajectories live, or a storyteller crafting branching scenes that evolve with audience input. The system streams frames continuously, taking motion signals as input and producing coherent video output, which makes long-form interactive experiences feel native and responsive.

Practical note, from my own tinkering: latency still matters, and lighting or highly detailed texture fidelity can wobble sometimes, but the interactivity more than makes up for it. You learn to work with the tool, not against it. Small aside, I love that it invites improvisation, you know, the “let’s see what happens” kind.

Looking forward, I expect lower latency, tighter integration with game engines, and mobile controllers becoming standard input devices. MotionStream opens up collaborative, real-time storytelling, and that excites me. If you want to explore, check the original writeup here: https://joonghyuk.com/motionstream-web/

MotionStream: Echtzeit-Videoerzeugung mit interaktiver Bewegungssteuerung

Stell dir vor, du steuerst ein Video, als würdest du einen Regler schieben, nur durch Bewegung. Genau das verspricht MotionStream. Es erzeugt Videos in Echtzeit, reagiert auf Bewegungssteuersignale und kann theoretisch beliebig lange Sequenzen streamen. Ich habe mir das Demo angesehen, und es fühlt sich an wie Improvisation mit Bildern, manchmal rau, oft überraschend schön.

Kurz zur Einordnung. Früher war Videogenerierung ein langsamer, iterativer Prozess, du rendertest, kontrolliertest, rendertest erneut. MotionStream macht daraus ein Live-Erlebnis, ideal für interaktive Kunst, Bühnenvisuals oder dynamische Spielwelten. Wichtig ist die zeitliche Konsistenz, damit das Bild nicht flackert, wenn du es steuerst.

Was bedeutet das konkret? Stell dir eine Band vor, deren Bewegungen die Hintergrundvisuals formen, oder ein Entwickler, der Kamerafahrten in Echtzeit anpasst. MotionStream nimmt Bewegungsdaten als Eingabe und liefert kontinuierlich kohärente Frames, so dass längere, interaktive Erzählungen möglich werden.

Meine praktische Beobachtung: Es ist nicht perfekt, Details wie extrem feine Texturen oder perfekte Beleuchtung können noch wackeln, und Latenz bleibt eine Herausforderung. Trotzdem lädt das System zum Ausprobieren ein, zum Improvisieren. Kleine Nebenbemerkung, das Chaos beim ersten Mal macht auch Spaß.

Ausblick? Mehr Performance, bessere Integration in Spiele-Engines und mobile Controller als Standard sind wahrscheinlich. MotionStream könnte Echtzeit-Kooperation und neue Formen des visuellen Geschichtenerzählens vorantreiben. Neugierig geworden? Hier ist der originale Artikel: https://joonghyuk.com/motionstream-web/

Kommentar abschicken