Agentic RAG with MCP Workflow Diagram

Agentic RAG with MCP, in plain terms

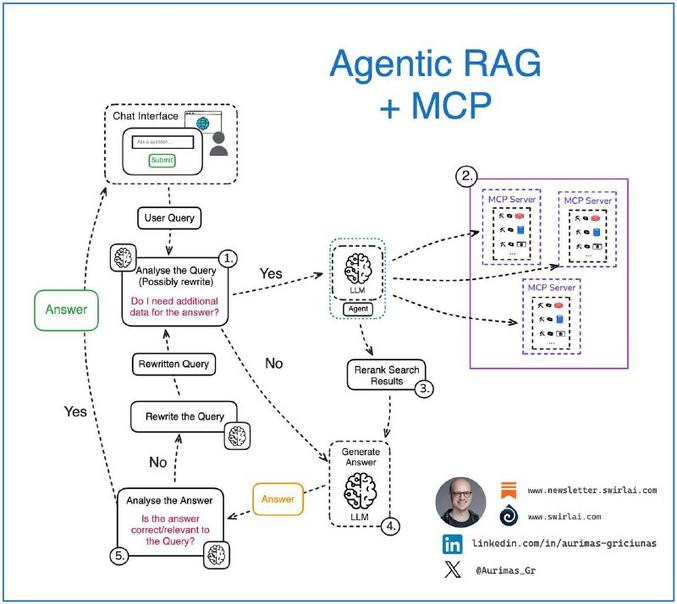

You’ve probably seen diagrams that look complicated at first, but once you walk through them they make sense. This flowchart shows how an *agentic RAG* setup works together with *MCP servers* to handle a user query. Think of it as a small team: the chat interface hears you, the language model thinks, and the MCP servers fetch receipts from the data store when needed.

Here’s the core idea. A user query arrives, it’s analyzed and sometimes rewritten (to make it clearer). If extra data is needed, the system asks MCP servers for relevant information. Results get reranked, so the language model gets the best possible context. The model builds an answer, and then that answer is checked for correctness and relevance before it goes back to you. Visually, the chart uses nodes and arrows, with blue and purple to separate components, which helps developers follow the flow quickly.

A little background. Retrieval-augmented generation, or RAG, grew out of a desire to combine search and reasoning, so models don’t have to “remember” everything. MCP-style servers add a managed, reliable data layer, which is great when the source matters and you need reproducibility. I’ve sketched similar flows while building prototypes, and the differences between a casual proof-of-concept and a production design become obvious fast (latency handling, reranking, and verification are where real work lives).

Practical example. You ask a product question, the system rewrites it for clarity, MCP returns policy docs, reranker picks the best snippets, the model crafts an answer, then a verification step flags anything uncertain. Simple in concept, but robust in practice.

Want to read more? Original deeplink: (none provided by source). Related resources: Retrieval-augmented generation on Wikipedia, LangChain docs.

Looking ahead, these patterns will get tighter, faster, and more trustworthy, and that’s a good thing for anyone building conversational systems.

Agentic RAG mit MCP, kurz erklärt

Manchmal sind Diagramme zuerst einschüchternd, später aber sehr nützlich. Dieses Flussdiagramm zeigt, wie ein *agentic RAG*-Ansatz zusammen mit *MCP-Servern* eine Nutzeranfrage bearbeitet. Stell es dir wie ein Team vor: die Chatoberfläche nimmt deine Anfrage, das Sprachmodell verarbeitet sie, und die MCP-Server liefern zusätzliche Daten, wenn nötig.

Kernablauf. Die Anfrage wird analysiert, eventuell umformuliert, damit sie klarer ist. Werden mehr Informationen gebraucht, fragt das System bei den MCP-Servern nach. Die Ergebnisse werden neu bewertet, damit das Sprachmodell den besten Kontext bekommt. Das Modell erzeugt eine Antwort, die anschliessend auf Korrektheit und Relevanz geprüft wird, bevor sie zurück an dich geht. Farben wie Blau und Lila trennen in der Grafik die Systeme, das macht die Übersicht einfacher.

Kurz zur Historie. RAG kombiniert Suche mit Generierung, damit Modelle nicht alles auswendig wissen müssen. MCP bringt eine verwaltete Schicht für verlässliche Daten, wichtig in produktiven Einsätzen. Aus eigener Erfahrung: im Prototyp läuft vieles schnell, in Produktionen zeigen sich Latenz, Reranking und Verifikation als die wahren Herausforderungen.

Praxisbeispiel. Du fragst nach Produktregeln, das System präzisiert die Anfrage, MCP liefert Richtlinien, ein Reranker wählt die besten Ausschnitte, das Modell antwortet, und eine Prüfinstanz markiert Unsicherheiten. Klingt simpel, wird aber robust.

Original deeplink: (keine Angabe). Weiterführende Links: Retrieval-augmented generation auf Wikipedia, LangChain Dokumentation.

Ich bin optimistisch, dass diese Muster schneller und verlässlicher werden, und das ist für alle, die Conversational-Systeme bauen, ein echter Gewinn.

Kommentar abschicken