Patterns in LLM Agent Interaction

Patterns in LLM Agent Interaction

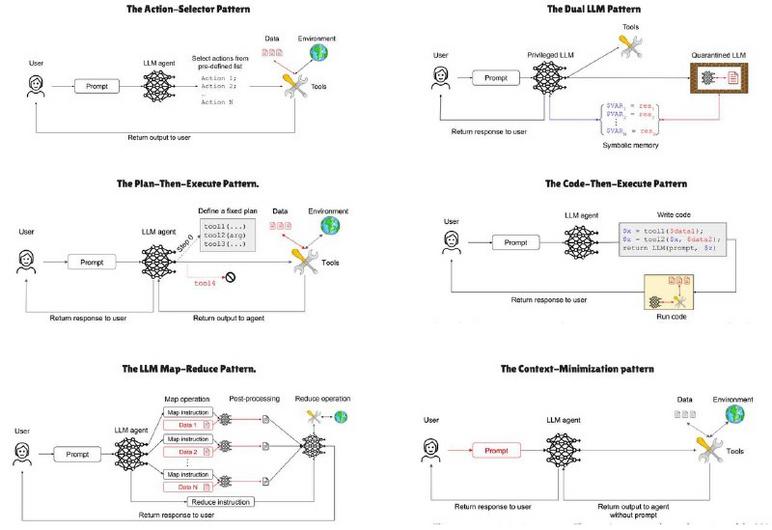

If you’ve ever stared at a dense diagram of AI architectures and felt your brain fog over, you’re not alone. I’ve been there, coffee in hand, trying to untangle how to get a model to do real work, not just produce pretty text. The image behind this post diagrams six practical ways to structure LLM-driven systems, and each pattern solves a different problem.

First, the core idea. These patterns are blueprints for making LLMs useful in the real world, whether you’re building a chatbot, an automation pipeline, or a secure assistant for sensitive tasks.

What the image shows, briefly:

– Action–Selector, choose from predefined actions, great when you want controlled, predictable behavior.

– Dual LLM, use one privileged model and one quarantined model for safety and compartmentalization.

– Plan–Then–Execute, have the model craft a plan, then run it step by step. Think of it like outlining then writing.

– Code–Then–Execute, generate code and execute it, useful for programmable tasks. Be cautious, because running code has risks.

– LLM Map–Reduce, split a big task into pieces, process them in parallel, then combine results, excellent for scaling.

– Context–Minimization, keep only the necessary context to save compute and reduce confusion.

A little history, quickly. These patterns grew out of need, as people tried to make LLMs more reliable, faster, and safer. Over time, developers borrowed ideas from classic software architecture, and adapted them to probabilistic models, not just rule-based systems.

Practical example, short: if you’re automating customer support, Action–Selector keeps replies safe, while Map–Reduce helps summarize large ticket histories quickly.

Want to dive deeper? See the original illustration and related notes here: https://platform.openai.com/docs/guides/agents

Looking ahead, these patterns will keep evolving, but they already give you a practical toolkit. Try one, tweak it, and let the system grow with your needs. It’s messy at first, then it clicks.

Muster in der LLM-Agenten-Interaktion

Wenn du schon einmal vor einer komplexen Grafik mit KI-Architekturen gesessen hast, dann kennst du dieses kleine Ziehen im Hirn, das sagt, „wie setze ich das praktisch ein?“ Ich erinnere mich daran, wie ich versucht habe, ein Modell zuverlässig zu machen, während der Kaffee kalt wurde. Die gezeigten Muster sind praktische Baupläne dafür.

Kurz und knapp, worum es geht:

– Action–Selector, vordefinierte Aktionen auswählen, gut für kontrolliertes Verhalten.

– Dual LLM, ein privilegiertes Modell und ein isoliertes Modell, für Sicherheit und Trennung.

– Plan–Then–Execute, erst planen, dann ausführen, nützlich bei mehrstufigen Aufgaben.

– Code–Then–Execute, Code erzeugen und ausführen, mächtig, aber mit Vorsicht zu genießen.

– LLM Map–Reduce, Aufgaben zerteilen, parallel bearbeiten, Ergebnisse zusammenführen, ideal zum Skalieren.

– Context–Minimization, nur relevante Informationen behalten, um Ressourcen zu sparen und Verwirrung zu vermeiden.

Kurz zur Herkunft: Diese Muster entstanden, weil Entwickler zuverlässigere, schnellere und sicherere Anwendungen bauen wollten. Man hat klassische Architekturprinzipien übernommen und an probabilistische Modelle angepasst.

Ein praktisches Szenario: Bei einer Support-Automatisierung sorgt Action–Selector für sichere Antworten, Map–Reduce fasst lange Ticket-Historien schnell zusammen.

Die Illustration und weiterführende Informationen findest du hier: https://platform.openai.com/docs/guides/agents

Ausblick, optimistisch: Diese Muster werden weiterreifen. Du kannst heute schon eins ausprobieren, anpassen und so ein System entwickeln, das mit deinen Anforderungen wächst. Es fühlt sich zuerst etwas chaotisch an, dann wird es klar.

Kommentar abschicken