Everything You Need to Know to Understand How LLMs Like ChatGPT Actually Work

Everything You Need to Know to Understand How LLMs Like ChatGPT Actually Work

You’ve probably asked ChatGPT or another AI something simple, then gotten an answer that felt slow, vague, or just off. I get that, I’ve been there too, pacing around the room, wondering what went wrong. The good news is you don’t need to be a mathematician to make sense of it, you just need the right words and a bit of practical intuition.

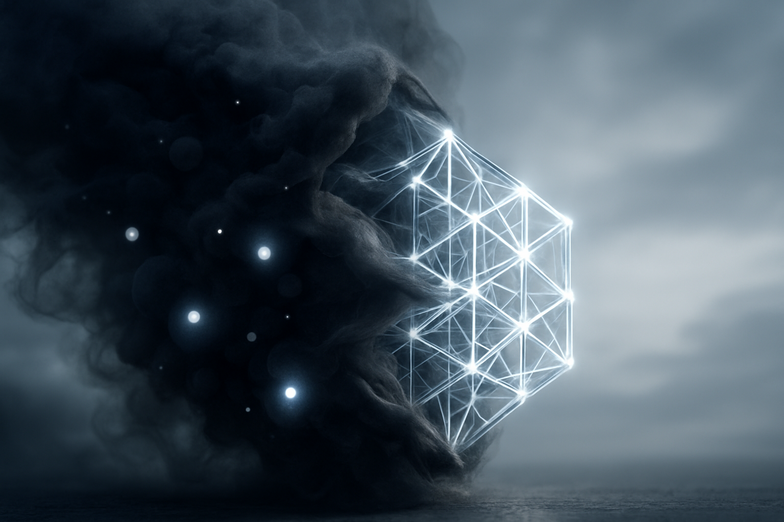

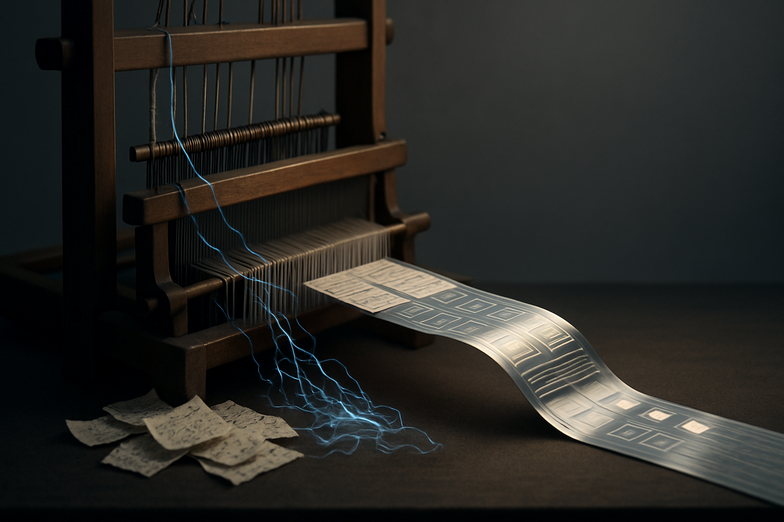

This post (based on a clear guide by Neo Kim and Louis‑François Bouchard) walks you through the essentials, thirty‑three concepts without the math, from tokens and embeddings to hallucinations and agents. Think of tokens like puzzle pieces, embeddings as the way the model maps pieces into a shared language, and hallucinations as the model confidently telling you it saw a unicorn when it didn’t. Simple metaphors help, and yes, they stick.

A little background, quickly: these models didn’t appear overnight. They’re the result of a decade of gradual progress, with a big “Aha” moment around 2022 when generative AI went mainstream. Today, knowing the vocabulary lets you spot failure modes, choose sensible settings, and get better outputs without endless prompt tweaking.

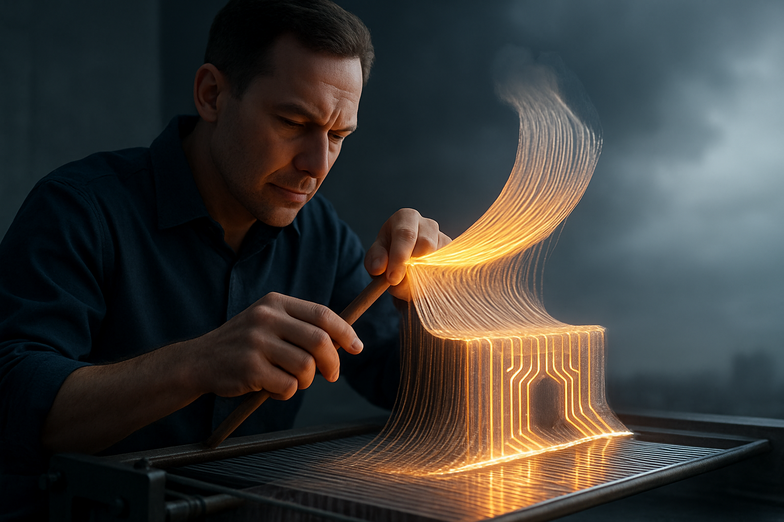

Practical example: if your answers are vague, check prompt clarity and token limits, or try a smaller context window, rather than blaming the model. If it invents facts, treat it like someone confidently guessing, and verify sources.

Want to dive deeper? Read the original guide here: https://newsletter.systemdesign.one/p/llm-concepts. Louis-François is turning this into videos too, which is handy if you prefer watching rather than reading.

In short, once you understand the building blocks, LLMs stop feeling like magic and start feeling like tools you can shape. And honestly, that’s pretty empowering. The future looks practical, not mystical, and we’re just getting started.

Alles, was Sie wissen müssen, um zu verstehen, wie LLMs wie ChatGPT tatsächlich funktionieren

Sie haben sicher schon eine Frage an ChatGPT oder ein ähnliches Tool gestellt und dann eine Antwort bekommen, die langsam, ungenau oder schlicht falsch war. Mir ging es genauso, mehrmals, in Meetings, at home, you name it. Das Problem ist oft kein Geheimnis, sondern fehlendes Vokabular.

Der Leitfaden von Neo Kim und Louis‑François Bouchard erklärt 33 Kernkonzepte ganz ohne Mathematik. Kurz gesagt: Tokens sind die Bausteine (wie Puzzle-Teile), Embeddings ordnen Bedeutung in einen Raum, und Halluzinationen sind, wenn das Modell fest überzeugt falsche Fakten erzählt. Klingt simpel, hilft aber enorm.

Ein kurzer Blick in die Geschichte: LLMs sind das Ergebnis eines Jahrzehnts Forschung, mit einem großen Durchbruch 2022, als generative KI für die breite Masse sichtbar wurde. Heute reicht oft ein Verständnis dieser Begriffe aus, um Fehlerquellen zu erkennen, Modelle sinnvoll auszuwählen und produktivere Interaktionen zu führen.

Ein praktischer Tipp: Wenn Antworten zu allgemein bleiben, überprüf deine Eingabe, die Kontextlänge und die Einstellungen. Wenn das Modell Fakten erfindet, behandle die Ausgabe wie eine Vermutung und prüfe Quellen nach.

Mehr dazu findest du im Originalartikel: https://newsletter.systemdesign.one/p/llm-concepts. Louis‑François macht daraus auch Videos, falls du lieber zusiehst. Kleiner Zwischenruf: das Lernen darf ruhig ein bisschen unordentlich sein, so wie echte Konversationen.

Am Ende fühlt sich KI weniger wie Magie an und mehr wie ein Werkzeug, das du bewusst einsetzen kannst. Und das ist eine ziemlich gute Aussicht.

Kommentar abschicken