How Claude Code Works – Jared Zoneraich, PromptLayer

How Claude Code Works — Jared Zoneraich, PromptLayer

I watched Jared Zoneraich’s talk, and it felt like someone quietly tearing down a complicated machine to show the simple gears that actually move it. If you want the video, here it is: How Claude Code Works.

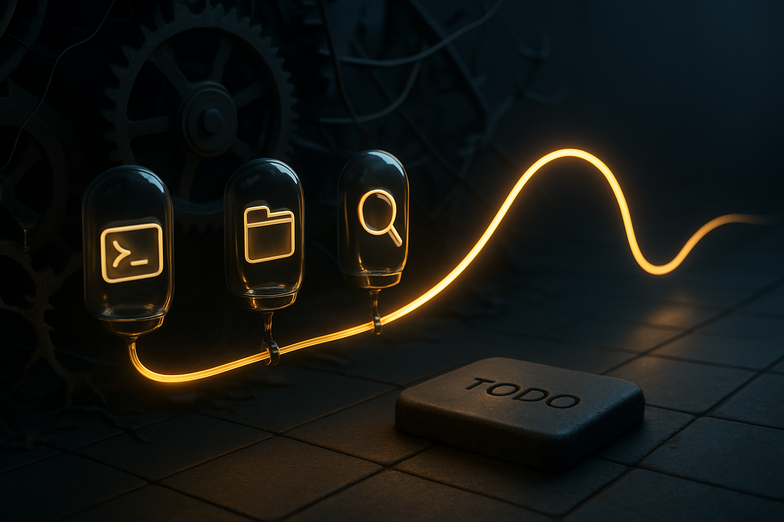

At the heart of Claude Code is one idea, and it’s almost refreshingly boring, in a good way: a single-threaded *Master Loop*, paired with very capable models. No sprawling directed acyclic graphs, no brittle choreography of many agents. Instead, give the model a small set of solid tools, like *Bash*, *FileEdit*, and *Grep*, and let it do the work. It plans via a simple *Todo* list, not by building a complex DAG, and that simplicity turns out to be powerful for reliability.

A few practical bits stood out to me. Sandboxing matters, a lot, because running code is dangerous without it. System prompts are tiny levers that shape what the agent can and cannot do, and sub-agents are really just specialized tool users, not mystical beings. Jared also warns about the “AI Therapist” problem, where an agent overthinks rather than executes, and that rang true from my own experiments, where a model stalled trying to be perfect instead of shipping changes.

Looking back, earlier agent architectures tried to orchestrate everything for you, and they broke in subtle ways. Claude Code’s approach is more like giving a skilled craftsman a good toolbox, then stepping aside. Moving forward, the talk points to better evaluation tools, headless SDKs for testing, and a shift toward spec-driven development, which feels promising for production use.

If you build with LLMs, try the simple route first. Give the model the right tools, lock the sandbox down, and use crisp system prompts. It won’t solve everything yet, but it gets you much farther, faster.

Deutsch

Ich habe Jared Zoneraichs Vortrag gesehen, und es wirkt fast so, als würde jemand komplizierte Technik auseinandernehmen, nur um die wenigen Zahnräder zu zeigen, die wirklich funktionieren. Das Video findest du hier: How Claude Code Works.

Die Kernidee von Claude Code ist überraschend schlicht, und gerade deshalb effektiv: eine *single-threaded Master Loop*, kombiniert mit leistungsfähigen Modellen. Keine aufgeblasenen DAG-Strukturen, keine fragilen Choreografien vieler Agenten. Stattdessen bekommt das Modell solide Werkzeuge, wie *Bash*, *FileEdit* und *Grep*, und arbeitet damit. Die Planung geschieht über eine einfache *Todo*-Liste, nicht über komplexe Graphen, und das zahlt sich in Zuverlässigkeit aus.

Zwei praktische Punkte sind wichtig. Erstens, Sandboxing ist unverzichtbar, denn Codeausführung ohne Sicherheitszone ist ein Risiko. Zweitens, System Prompts sind kleine Hebel, die das Verhalten des Agenten klar formen. Sub-Agenten sind eher spezialisierte Werkzeugnutzer als eigenständige Intelligenzen. Jared erwähnt auch das „AI Therapist“ Problem, also das Überanalysieren statt Ausführen, das ich aus eigenen Tests gut kenne, wenn ein Modell lieber perfektioniert statt liefert.

Früher versuchten Architekturen alles zu orchestrieren, und das führte oft zu subtilen Fehlern. Claude Code ist eher wie ein Handwerker mit gutem Werkzeug, dem man den Raum lässt. In Zukunft helfen bessere Evaluationswerkzeuge, Headless SDKs und spec-getriebene Entwicklung, um LLMs sicherer in Produktion zu bringen.

Wenn du mit LLMs arbeitest, fang einfach an. Gib dem Modell die richtigen Tools, sichere die Sandbox, und formuliere klare System Prompts. Es ist kein Wundermittel, aber es bringt dich deutlich weiter.

Kommentar abschicken