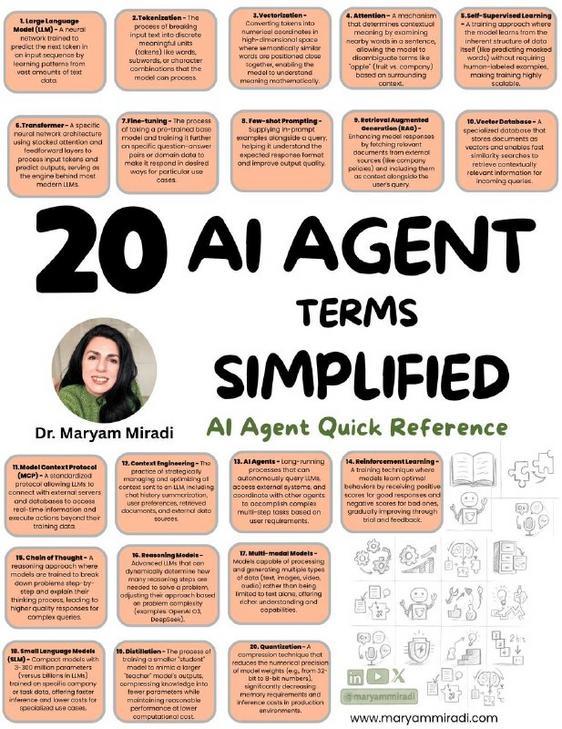

20 AI Agent Terms Simplified

Quick Guide: 20 AI Agent Terms, Simplified

If you’ve ever felt like AI talks in its own language, you’re not alone. I kept getting stuck on words like tokenization and attention, until I found a neat visual cheat sheet that lays out 20 key terms in plain language. The image uses orange boxes, clear colors, and short explanations, so it’s actually readable, not intimidating. There’s even a photo of Dr. Maryam Miradi included, which made it feel more human to me, like someone stood next to the diagram and explained things over coffee.

Here’s the core idea, in a few friendly bites. The sheet covers basics like Large Language Model, which is the big pattern-finding engine, and Tokenization, which is how text gets chopped into pieces the model can handle. It also explains Transformer architecture, Attention mechanisms, and prompts like few-shot prompting, short examples that teach the model on the fly. The design helps you see relationships, so concepts click faster.

A bit of background, because context helps. These ideas come from decades of research, but the real jump came when models learned to weigh context better, via attention, and to process language as tokens, not whole sentences. That shift made today’s assistants much more flexible.

Practical takeaway, if you want to use this: skim the image, pick three terms that feel most confusing, and try a quick example in a playground or notebook. I did that last week, and suddenly prompts made sense, step by step.

Deeplink to the summarized image: (no deeplink was provided)

Further reading: https://jalammar.github.io/illustrated-transformer/

Looking ahead, these terms will keep evolving, but with simple references like this one, learning stays doable, even fun.

Schnelle Übersicht: 20 KI-Agenten-Begriffe, vereinfacht

Wenn KI-Begriffe wie Tokenization oder Attention für dich nach Fachchinesisch klingen, das ist normal. Ich habe mir neulich eine übersichtliche Grafik angesehen, die 20 Begriffe in orangefarbenen Kästchen erklärt, kurz und klar. Ein Foto von Dr. Maryam Miradi macht das Ganze menschlicher, fast so, als würde dir jemand die Begriffe persönlich erklären.

Kurz und praktisch: Die Grafik erklärt Grundbegriffe wie Large Language Model (das große Sprachmodell), Tokenization (wie Text in verarbeitbare Teile zerlegt wird) und Transformer oder Attention (wie das Modell Kontext gewichtet). Auch Techniken wie few-shot prompting sind enthalten, das heißt, man gibt dem Modell ein paar Beispiele, statt es komplett neu zu trainieren.

Etwas Hintergrund hilft: Viele dieser Konzepte stammen aus langer Forschung, doch der Durchbruch kam, als Modelle gelernt haben, Kontext gezielt zu nutzen. Dadurch sind heutige Agenten flexibler geworden und lassen sich leichter mit einfachen Beispielen steuern.

Mein Tipp zum Lernen: Such dir drei Begriffe aus, die du noch nicht klar hast, und probiere kurze Experimente in einer Testumgebung. Ich habe das gemacht, und kleine Versuche halfen enorm beim Verstehen.

Deeplink zur Grafik: (kein Deeplink wurde bereitgestellt)

Weiterführend: https://jalammar.github.io/illustrated-transformer/

Kurz gesagt, mit klaren, einfachen Referenzen bleibt der Lernweg überschaubar, und die Zukunft sieht vielversprechend aus.

Kommentar abschicken